Com deep learning, carros do futuro perceberão se você está feliz ou triste

Por

Quando

nós divulgamos notícias sobre carros capazes de ler emoções, geralmente

falamos sobre conceitos futuristas que prometem que isso vai acontecer

um dia, mas que ainda não fazem de fato. Se depender de uma empresa

chamada Affectiva, no entanto, a história muda de figura.

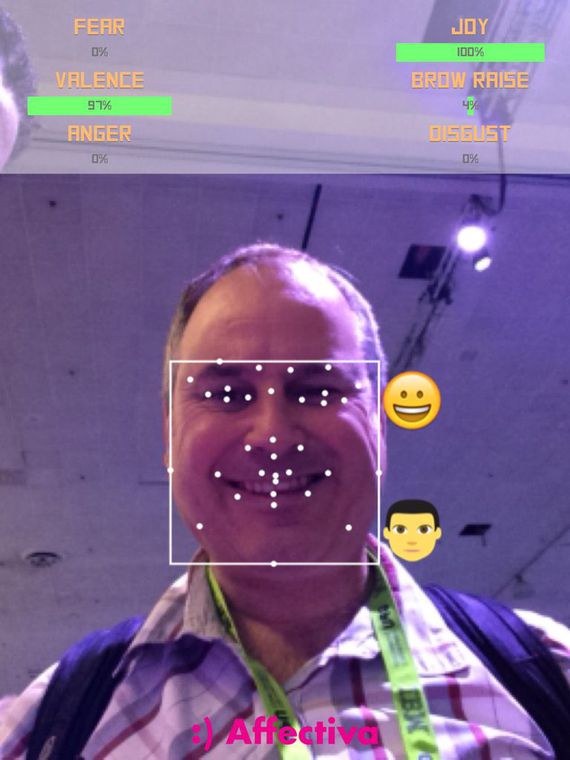

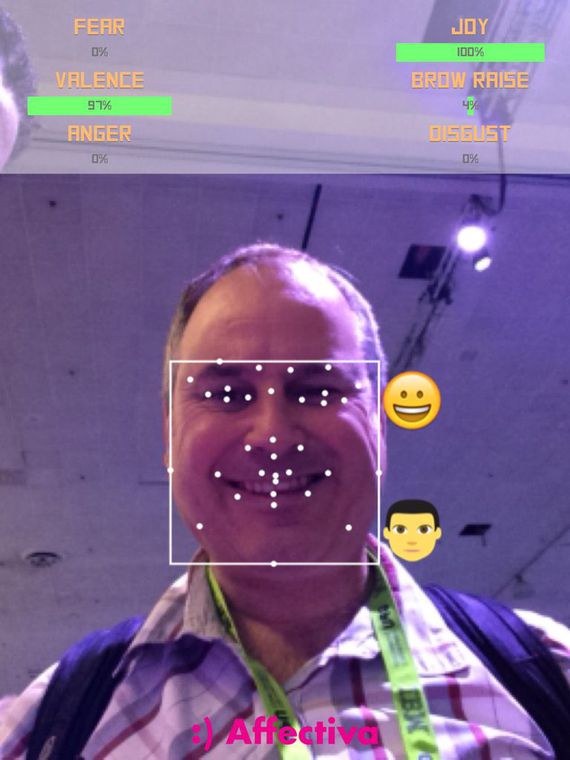

Depois de oito anos, a companhia criou uma engine que é capaz de reconhecer emoções e está sendo desenvolvida para ser utilizada em carros. Mas e daí, o que fazer com esse reconhecimento? Bem, a ideia principal é que o sistema consiga, por exemplo, alertar condutores distraídos, acalmar os mais nervosinhos e, no caso dos carros autônomos, encontrar a melhor forma e o melhor momento para entregar a direção para o motorista.

Isso porque é sabido que os sistemas de condução autônoma estão tirando cada vez mais atividades da mão dos humanos, mas, como isso ainda não acontece de forma integral, a ideia é que o condutor esteja sempre pronto para assumir o comando do veículo – é aí que essa transição de forma fluida precisa ser feita, principalmente se o motorista tiver ficado afastado do controle do veículo durante muito tempo.

Além disso, o gerente de produto da Affectiva, Abdelrahman Mahmoud, acredita que o fato de o carro estar ciente do estado emocional dos passageiros pode ser utilizado para ajustar a forma como o sistema conduz o veículo. Se ele detectar que eles estão aflitos ou com medo, uma direção menos agressiva pode ser adotada; caso eles estejam confusos com o caminho, o sistema pode mostrar a rota e o destino final na central multimídia para assegurar que o carro sabe para onde está indo.

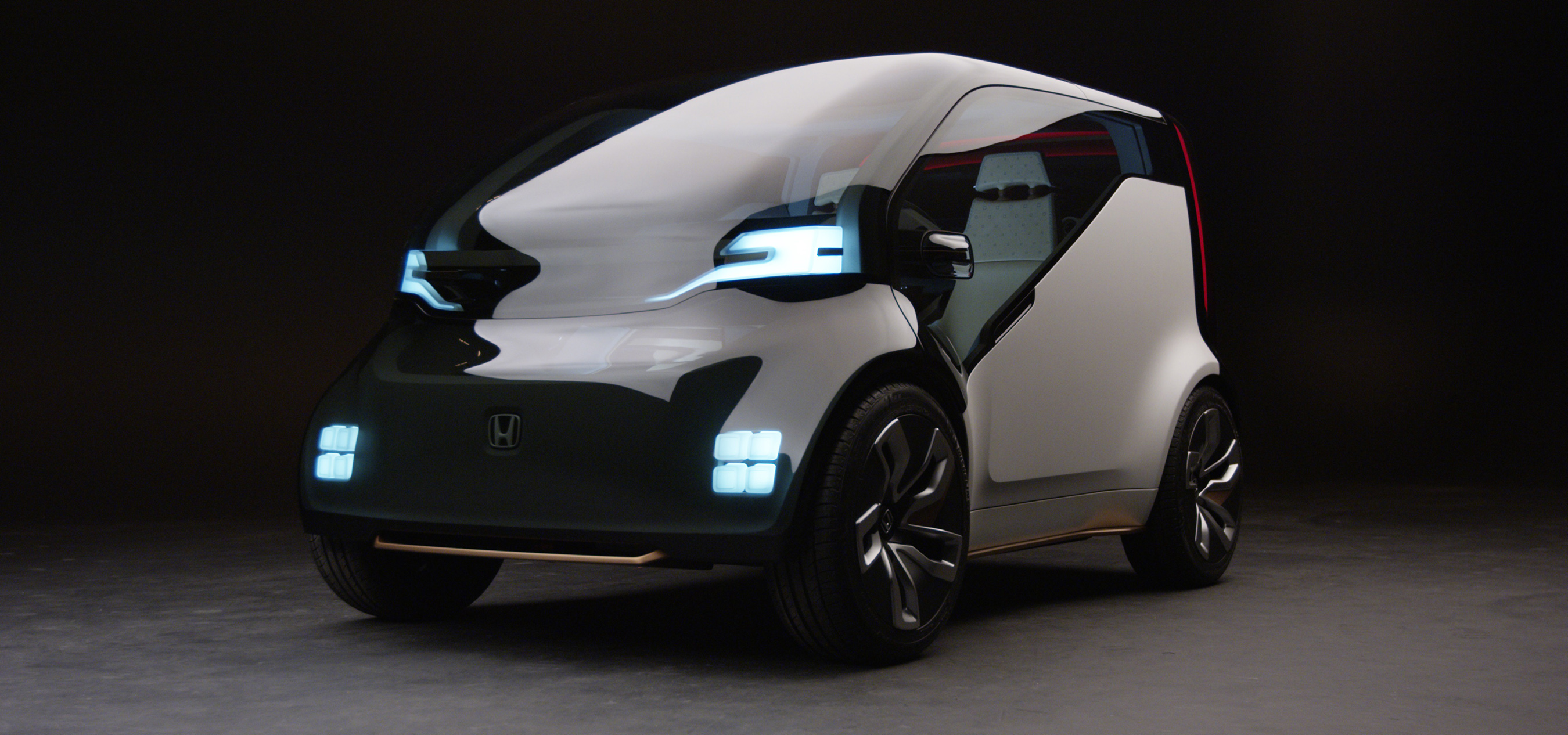

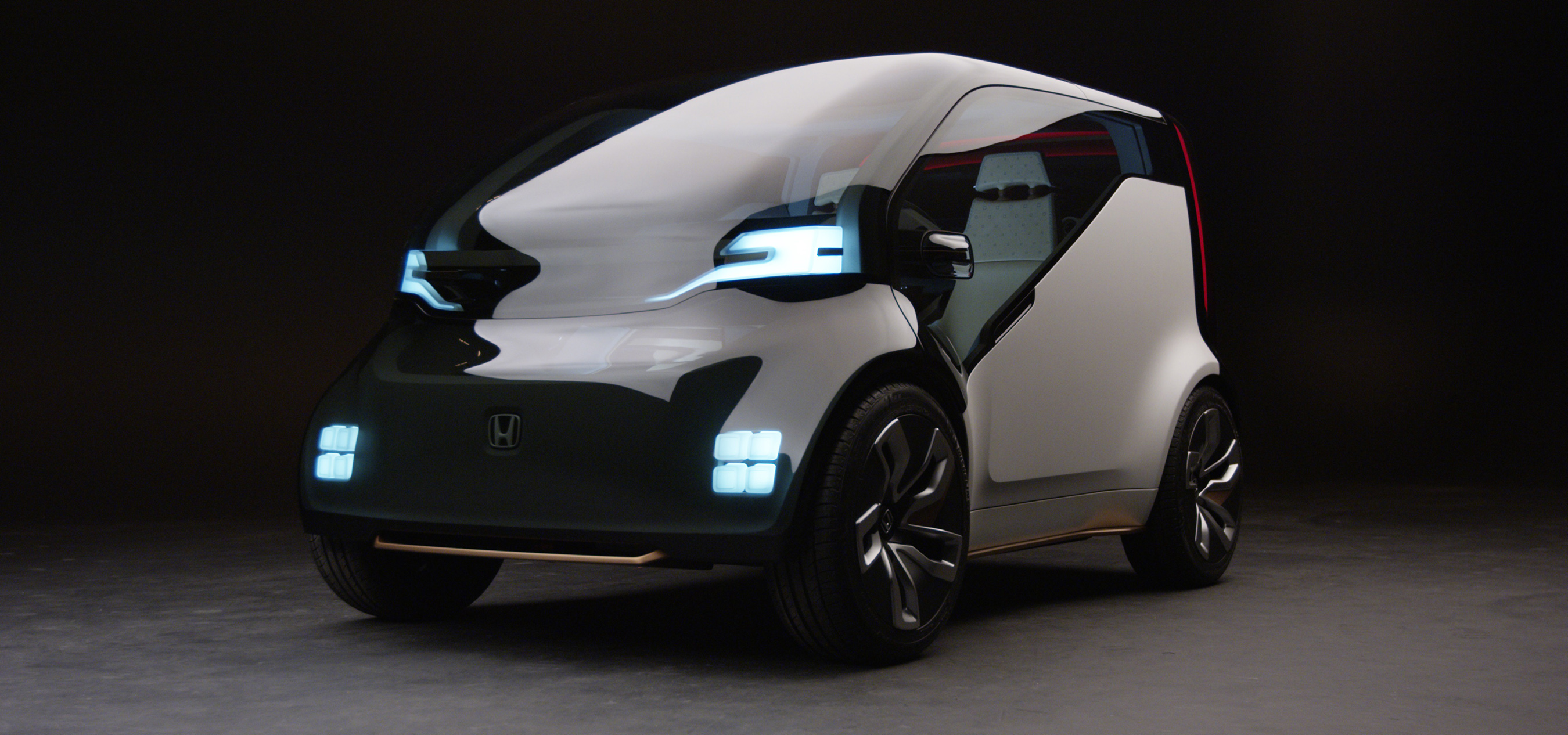

Honda NeuV é um dos conceitos que promete se conectar aos sentimentos do condutor

A engine da empresa usa câmeras voltadas para os ocupantes do carro e é capaz de identificar até 33 pontos faciais. Essa informação é interpretada pela rede neural do computador, com base no processo de deep learning da Affectiva, que já estudou mais de 5 milhões de expressões faciais.

Elas são então separadas em sete emoções, como alegria, surpresa e medo, além de outros atributos importantes, como é o caso do engajamento do ocupante com o sistema. O interessante é que, segundo Mahmoud, a companhia buscou alimentar o processo de deep learning com expressões faciais de 75 países, já que as feições podem variar bastante.

O executivo citou o caso dos sorrisos, que têm o mesmo formato básico em todas as culturas, mas variam em intensidade – no caso da Tailândia, por exemplo, o sorriso é mais sutil que em outros países.

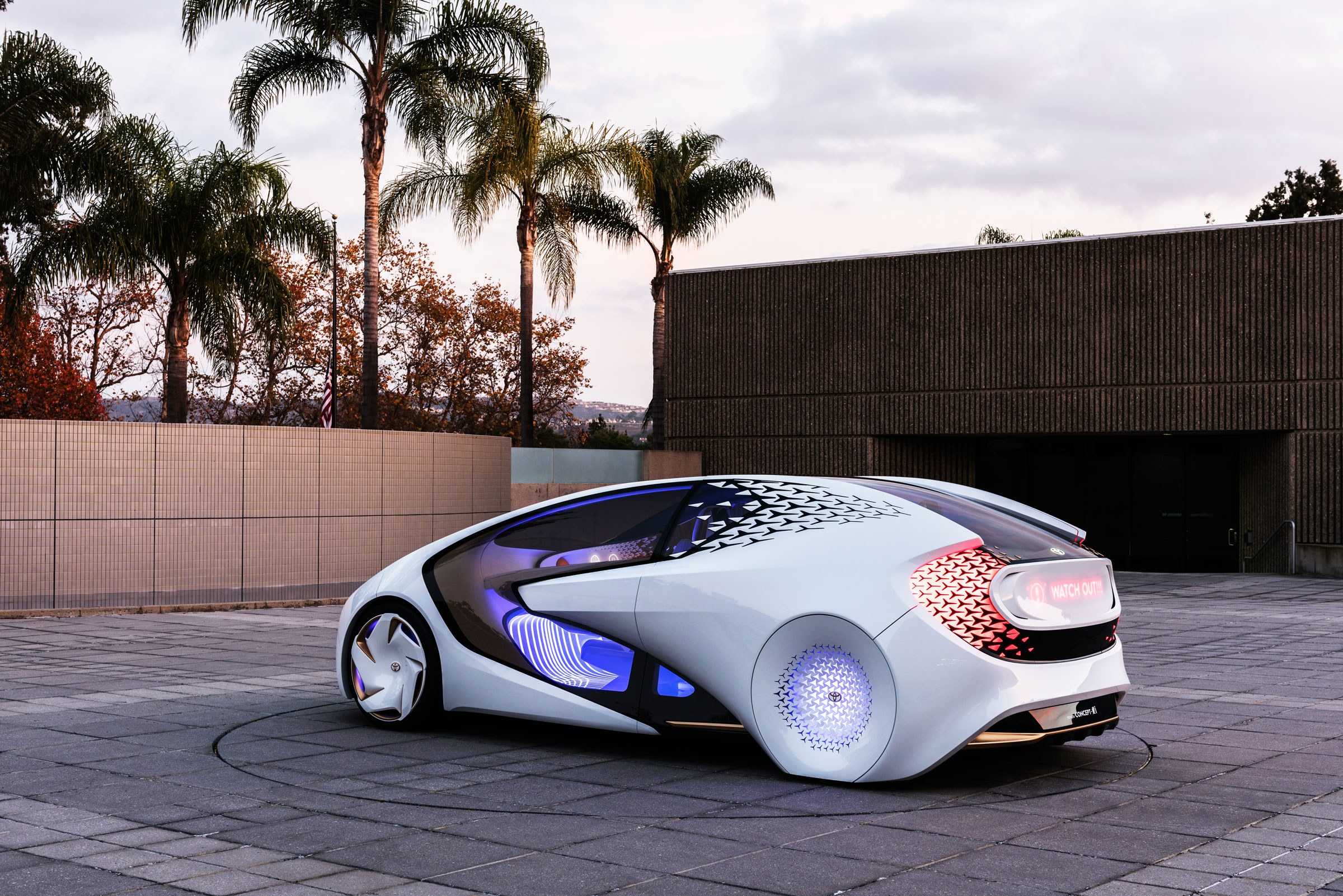

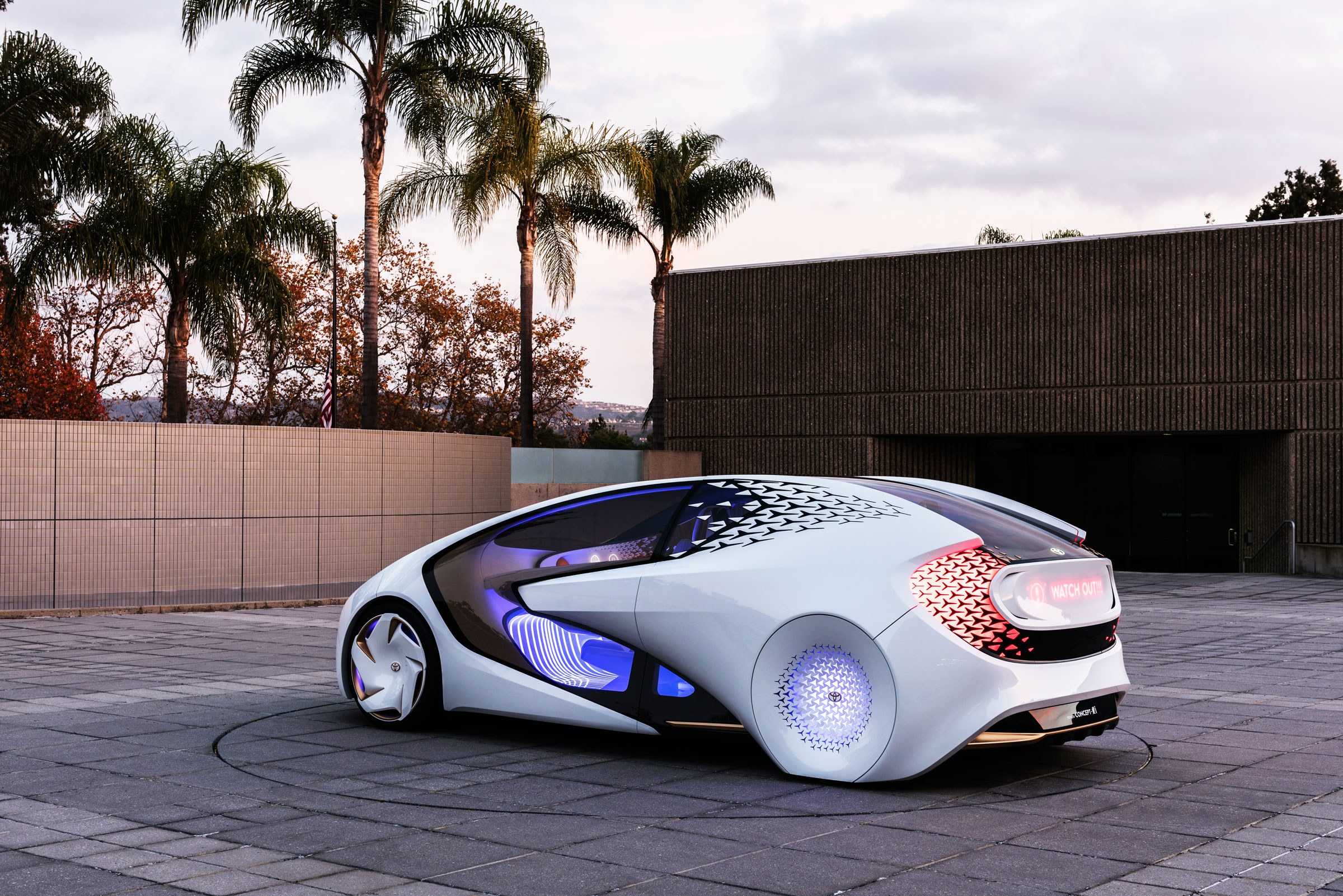

E a Toyota não ficou para trás com o Concept-i, que é quase um cachorro em forma de carro

Apesar de isso tudo soar meio estranho, você não precisa se preocupar: nenhuma informação visual é gravada pelo sistema da Affectiva e todo o reconhecimento de emoções é feito na estrutura individual do veículo. As únicas informações trocadas entre a engine e um servidor são os eventuais updates que melhoram a precisão do sistema.

Mahmoud afirmou que a empresa está trabalhando junto com algumas montadoras alemãs e japonesas – Toyota e Honda, talvez? –, e já antecipou que um protótipo já deverá dar as caras no ano que vem.

Depois de oito anos, a companhia criou uma engine que é capaz de reconhecer emoções e está sendo desenvolvida para ser utilizada em carros. Mas e daí, o que fazer com esse reconhecimento? Bem, a ideia principal é que o sistema consiga, por exemplo, alertar condutores distraídos, acalmar os mais nervosinhos e, no caso dos carros autônomos, encontrar a melhor forma e o melhor momento para entregar a direção para o motorista.

Isso porque é sabido que os sistemas de condução autônoma estão tirando cada vez mais atividades da mão dos humanos, mas, como isso ainda não acontece de forma integral, a ideia é que o condutor esteja sempre pronto para assumir o comando do veículo – é aí que essa transição de forma fluida precisa ser feita, principalmente se o motorista tiver ficado afastado do controle do veículo durante muito tempo.

Além disso, o gerente de produto da Affectiva, Abdelrahman Mahmoud, acredita que o fato de o carro estar ciente do estado emocional dos passageiros pode ser utilizado para ajustar a forma como o sistema conduz o veículo. Se ele detectar que eles estão aflitos ou com medo, uma direção menos agressiva pode ser adotada; caso eles estejam confusos com o caminho, o sistema pode mostrar a rota e o destino final na central multimídia para assegurar que o carro sabe para onde está indo.

Honda NeuV é um dos conceitos que promete se conectar aos sentimentos do condutor

A engine da empresa usa câmeras voltadas para os ocupantes do carro e é capaz de identificar até 33 pontos faciais. Essa informação é interpretada pela rede neural do computador, com base no processo de deep learning da Affectiva, que já estudou mais de 5 milhões de expressões faciais.

Elas são então separadas em sete emoções, como alegria, surpresa e medo, além de outros atributos importantes, como é o caso do engajamento do ocupante com o sistema. O interessante é que, segundo Mahmoud, a companhia buscou alimentar o processo de deep learning com expressões faciais de 75 países, já que as feições podem variar bastante.

O executivo citou o caso dos sorrisos, que têm o mesmo formato básico em todas as culturas, mas variam em intensidade – no caso da Tailândia, por exemplo, o sorriso é mais sutil que em outros países.

E a Toyota não ficou para trás com o Concept-i, que é quase um cachorro em forma de carro

Apesar de isso tudo soar meio estranho, você não precisa se preocupar: nenhuma informação visual é gravada pelo sistema da Affectiva e todo o reconhecimento de emoções é feito na estrutura individual do veículo. As únicas informações trocadas entre a engine e um servidor são os eventuais updates que melhoram a precisão do sistema.

Mahmoud afirmou que a empresa está trabalhando junto com algumas montadoras alemãs e japonesas – Toyota e Honda, talvez? –, e já antecipou que um protótipo já deverá dar as caras no ano que vem.

Fonte(s):Roadshow

Fonte: Tecmundo

Comentários

Postar um comentário

Todas postagem é previamente analisada antes de ser publicada.